Redes de Kolmogorov-Arnold y el problema Hilbert 13

En este artículo les hablaremos sobre una nueva arquitectura de redes neuronales propuesta hace algunas semanas por investigadores del Massachusetts Institute of Technology, Caltech, Northeastern University y el NSF AI Institute for Artificial Intelligence and Fundamental Interactions (IAIFI).

Esta arquitectura se llama Kolmogorov-Arnold Network y se ha reportado que tienen grandes ventajas tanto computacionales como de interpretabilidad sobre las clásicas redes neuronales densas.

La idea matemática detrás de esta arquitectura está basada en uno de los teoremas más importantes del siglo pasado el cual además resolvió negativamente el décimo tercer problema en la famosa lista de Hilbert con los problemas más importantes en matemáticas.

Una pregunta provocadora y el problema 13 de Hilbert

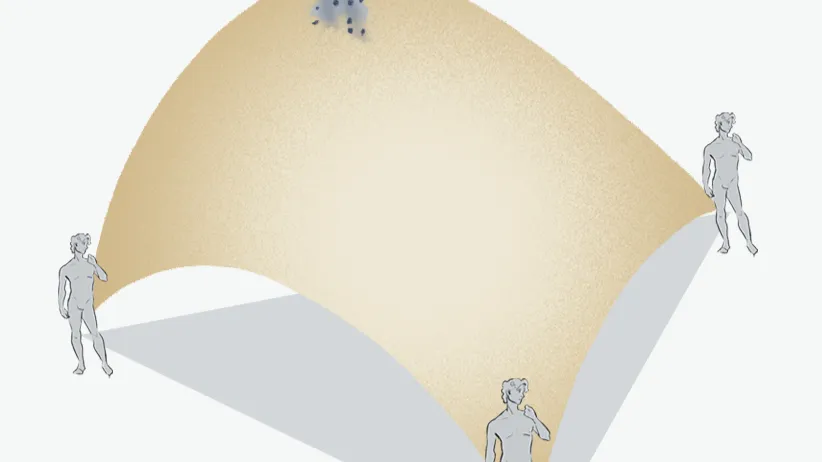

Imaginemos una función multivariada cualquiera como por ejemplo las que aprenden los modelos de Machine Learning en las que las distintas coordenadas corresponden con variables explicativas dentro de nuestros datos.

Todos los científicos de datos están familiarizados con la importancia de las técnicas multivariadas pues es en la interacción entre nuestras características donde se pueden encontrar patrones interesantes.

Para poner un ejemplo simple, en un problema de NLP podría ocurrir que no exista una palabra en nuestro vocabulario que nos ayude a realizar una predicción con alta eficacia (hablemos de análisis de sentimientos, de topic modeling o muchas otras tareas), sin embargo en la combinación entre las palabras es cuando podría encontrarse la señal.

Una de las funciones multivariadas más importantes es sin lugar a dudas la suma, esta operación es la base de todos los modelos lineales en los que se combinan las características por medio de distintos pesos los cuales en el caso de las redes densas son parámetros aprendibles de acuerdo a la base de datos.

Existen otras funciones multivariadas como por ejemplo la multiplicación, la función softmax, los polinomios, la distancia euclidiana y un gigantesco etcétera. Durante el Congreso Internacional de las Matemáticas en París en el año 1900, el famoso matemático David Hilbert propuso el siguiente problema el cual estaba en el lugar 13 de su famosa lista:

¿Es posible representar a todas las funciones multivariadas continuas utilizando únicamente a la suma, la composición y funciones univariadas continuas?

La versión original de este problema está enunciada en términos de soluciones algebraicas para las ecuaciones polinomiales de grado 7 sin embargo el teorema de representación de Kolmogorov-Arnold resolvió el problema para el caso continuo.

Como un ejemplo del teorema de Kolmogorov-Arnold consideremos la complicada representación de la multiplicación entre dos variables X,Y:

e^[log(X+1)+log(Y+1)] + (−X −1/2 )+(−Y−1/2)

Notemos que con esta manera de escribirlo, podemos utilizar únicamente a la suma como función multi-variada y a la composición de funciones uni-variadas para representar a la multiplicación.

Para los científicos de datos el resultado demostrado por Kolmogorov-Arnold es verdaderamente sorprendente pues de alguna manera justifica el uso de la suma como la única función multivariada genuina.

Kolmogorov Arnold Networks

Las redes neuronales KAN propuestas en este trabajo proponen una arquitectura que sustituya al perceptrón en donde los tradicionales pesos aprendibles serán sustituidos por funciones univariadas aprendibles las cuales posiblemente no son lineales.

La intuición detrás de estas arquitecturas es el teorema de representación de Kolmogorov-Arnold y los investigadores reportaron mejoras tanto desde el punto de vista computacional pues estas arquitecturas son más veloces como desde el punto de vista de la interpretabilidad, notemos que ahora no tenemos problemas de explicar complicadas interacciones entre las variables.

¿Dónde aprender matemáticas?

- Track de Ciencia de Datos. (49 semanas).

- Machine Learning & AI for the Working Analyst ( 12 semanas).

- Matemáticas para Ciencia de Datos ( 24 semanas).

- Especialización en Deep Learning. (12 semanas).

- Track de Finanzas Cuantitativas (49 semanas)

- Aplicaciones Financieras De Machine Learning E IA ( 12 semanas).

- Las matemáticas de los mercados financieros (24 semanas).

- Deep Learning for Finance (12 semanas).