Inferencia bayesiana (según T. Tao)

Bienvenidos a nuestra nueva edición de Bourbakisme en donde hablaremos sobre Inferencia Bayesiana y en particular presentaremos un diagrama propuesto por el matemático Terence Tao que nos permitirá estructurar el razonamiento bayesiano.

Tanto los modelos matemáticos como el cálculo de una probabilidad son tareas que dependen de las hipótesis que nosotros estamos dispuesto a asumir sobre el fenómeno que se analiza. Es muy importante que todos los actores relacionados con los modelos de predicción ya sea como desarrolladores, analistas o usuarios estén consientes de lo anterior.

Lo anterior no significa que no debamos considerar la evidencia a la que tenemos acceso durante la observación del fenómeno. Quizás la mejor manera de compaginar estas dos características del modelado matemático es lo que hoy conocemos como Inferencia Bayesiana y la cual es una de las herramientas más poderosas para realizar un análisis.

Thomas Bayes

La inferencia bayesiana como la conocemos hoy en día es el resultado de utilizar el teorema de bayes para actualizar el cálculo de probabilidades utilizando evidencia. Este teorema fue demostrado por primera vez por el matemático Thomas Bayes en 1763 en su texto An Essay towards solving a Problem in the Doctrine of Chances.

Terence Tao

Aunque esta tarea parezca ociosa, si estuviéramos obligados a nombrar quiénes son los matemáticos activos más sobresalientes, sería prácticamente imposible no pensar en el Profesor de UCLA Terence Tao quien dedica sus investigaciones a una basta variedad de problemas. Tanto sus ideas originales como su razonamiento prístino y poder técnico lo han convertido en una referencia mundial desde hace varias décadas.

Hace algunas semanas publicó en su blog un diagrama que él propone para estructurar sistemáticamente el razonamiento bayesiano y nos alegra mucho poderlo compartir en esta edición.

El problema de la bella durmiente

A continuación presentamos un ejemplo de un acertijo en teoría de la decisión que fue propuesto originalmente por Arnold Zuboff. Supongamos que la bella durmiente participará en el siguiente experimento que comienza el día domingo:

- El día domingo por la tarde se anestesiará a la bella durmiente.

- Inmediatamente después se lanzará una moneda justa (50% cara y 50% cruz) para decidir si se despertará solo el lunes o tanto lunes y martes a la bella durmiente.

- Después despertar a la bella durmiente (ya sea en lunes o martes) se volverá a anestesiar y se le aplicará un medicamento que la hace olvidar que ha sido despertada.

- El día miércoles termina el experimento y se despertará a la bella durmiente.

- En cualquier momento que despertemos a la bella durmiente le preguntaremos si cree que la moneda cayó cara o cruz.

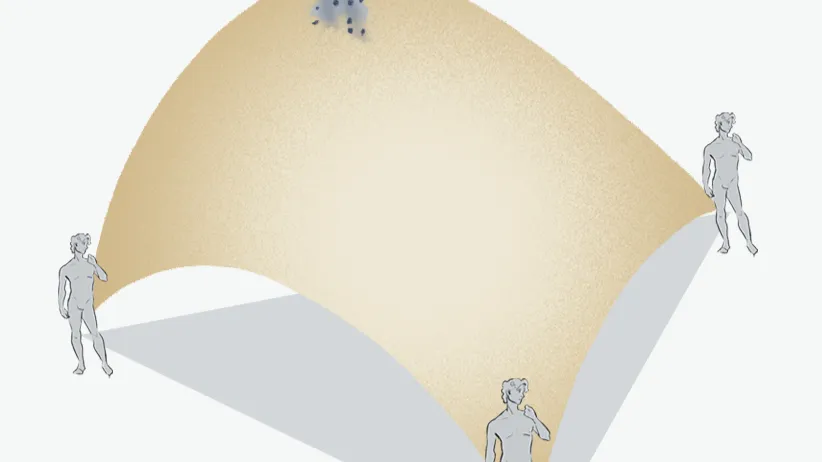

A continuación presentamos el diagrama que propone Terence Tao para estructurar gráficamente esta actualización bayesiana en el caso del problema de la Bella Durmiente.

En este caso la evidencia E que ella tiene es que ha sido despertada y utilizando el Teorema de Bayes se calculan las probabilidades posteriores (sujetas a la evidencia) de que el resultado de la moneda haya sido cara o cruz. Notemos que la hipótesis alternativa tiene una menor probabilidad de lo que hubiéramos imaginado.

¿Dónde aprender más?

Si está interesados en conocer más sobre las redes neuronales profundas y sus aplicaciones en la industria, el Colegio de Matemáticas Bourbaki ofrece dos cursos que podrían ser de su interés:

- Track de Ciencia de Datos. (49 semanas).

- Machine Learning & AI for the Working Analyst ( 12 semanas).

- Matemáticas para Ciencia de Datos ( 24 semanas).

- Especialización en Deep Learning. (12 semanas).

- Track de Finanzas Cuantitativas (49 semanas)

- Aplicaciones Financieras De Machine Learning E IA ( 12 semanas).

- Las matemáticas de los mercados financieros (24 semanas).

- Deep Learning for Finance (12 semanas).

Referencia

Invitamos a los interesados a visitar el artículo original de Terence Tao en donde explica lo anterior con enorme detalle y claridad.